Tệp robots.txt là một tài liệu đặc biệt được đặt trong thư mục gốc của trang web để chỉ định các quy tắc và hạn chế về việc truy cập của các robot (còn được gọi là web crawler, spider hoặc bot) từ các công cụ tìm kiếm hoặc các robot trên Internet.

Các công cụ tìm kiếm đọc tệp robots.txt trước khi bắt đầu quét và lập chỉ mục nội dung của trang web. Nó được sử dụng để thông báo cho các robot biết những phần của trang web mà bạn muốn cho phép hoặc không cho phép họ truy cập.

Ví dụ, bạn có thể sử dụng tệp robots.txt để từ chối các robot truy cập vào các thư mục cụ thể của trang web hoặc cấu hình để chỉ cho phép truy cập vào một số phần cụ thể của trang web. Ngoài ra, tệp robots.txt cũng cung cấp thông tin về phạm vi lập chỉ mục của các công cụ tìm kiếm và tần suất quét của chúng.

Tuy nhiên, cần nhớ rằng tệp robots.txt chỉ là một yêu cầu và không phải là một biện pháp bảo mật tuyệt đối. Cũng cần lưu ý rằng có thể có các robot không tuân thủ tệp robots.txt và tiếp tục quét toàn bộ dữ liệu của trang web hoặc truy cập vào các tệp tin để thu thập hoặc đánh cắp thông tin từ trang web. Điều này có liên quan đến việc ai điều khiển robot và mục đích cuối cùng của họ.

Vậy File Robots.txt nằm ở đâu ?

Tệp robots.txt sẽ được đặt trong thư mục gốc của trang web, tức là thư mục chứa tất cả các tệp và thư mục khác của trang web.

Cụ thể ví dụ: https://nhanhmedia.com/robots.txt.

File robots.txt mặc định sẽ không có trên website mà quản trị viên phải tạo để khai báo các rules cho các web crawler, spider hoặc bot biết

Robots.txt bao gồm cách thành phần gì ?

Tệp robots.txt bao gồm bốn thành phần chính:

- User-agent: Đây là phần định danh các robot cụ thể mà quy tắc sẽ áp dụng cho chúng. Đối với mỗi loại robot, bạn có thể chỉ định các quy tắc khác nhau.

- Disallow: Phần này chỉ ra các phần của trang web mà bạn muốn từ chối robot truy cập. Nếu một robot gặp phần được chỉ định trong phần Disallow, nó sẽ không quét hoặc lập chỉ mục phần đó của trang web.

- Allow: Tuy chọn, phần này cho phép bạn chỉ định các phần cụ thể mà bạn muốn cho phép robot truy cập, trong trường hợp bạn đã từ chối toàn bộ thư mục nhưng muốn cho phép một số phần cụ thể.

- Các chỉ thị khác: Ngoài các chỉ thị Disallow và Allow, tệp robots.txt cũng có thể chứa các chỉ thị khác như Sitemap, Crawl-delay, hay Host. Ví dụ, Sitemap chỉ định vị trí của sitemap XML của trang web, giúp các công cụ tìm kiếm hiểu cấu trúc của trang web một cách tốt hơn.

Làm như thế nào để sửa file Robots.txt cho wordpress

Việc tạo file robots.txt và sửa đổi file robots.txt rất đơn giản, bạn có thể đăng nhập vào hosting hoặc đăng nhập vào tài khoản FTP của bạn, tiếp theo truy cập vào vị trí chứa mã nguồn chứa website WordPress và tạo mới 1 file với tên là: robots.txt là xong

Nếu các bạn sử dụng plugin để tạo như Rank Math Seo, Yoat Seo… Thì các bạn sẽ truy cập vào quản trị của công cụ đó và tìm đến File Robots.txt để sửa

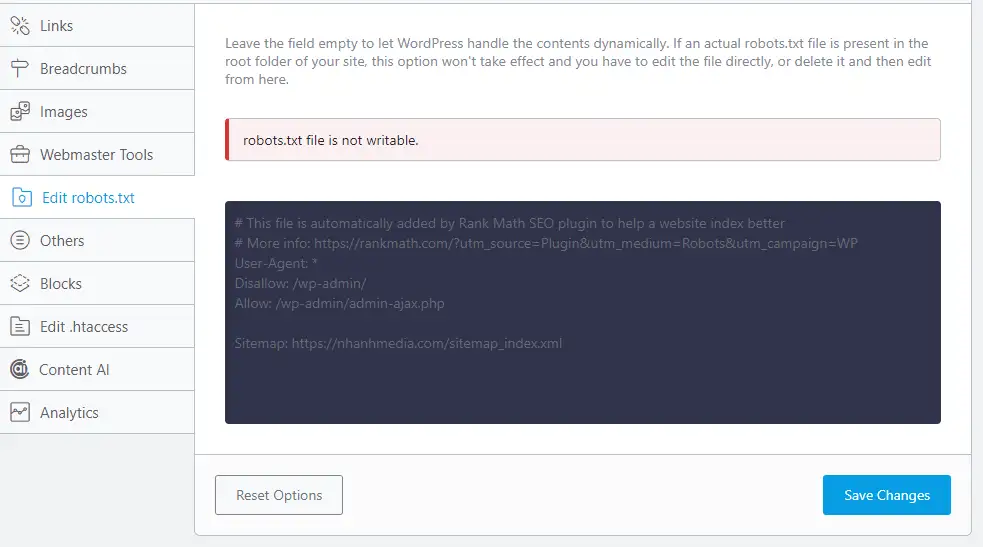

Lưu ý: nếu không sửa được File Robots.txt

Nếu website của bạn không có phép chỉnh sửa File Robots.txt như ảnh dưới đây.

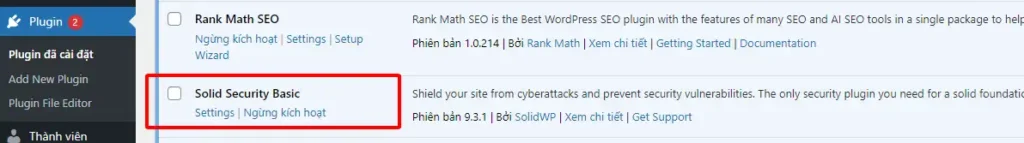

Thì các bạn khắc phục như sau: thường lỗi này là do đang có Plugin bảo mật đang cố bảo vệ website của bạn. Thì bạn chỉ cần tìm vào Plugin bảo mật và tắt chúng đi.

Ví dụ plugin: Solid Security Basic … thì bạn chỉ cần ngưng kích hoạt và sửa chúng. Sau khi xong nhớ bật lại chúng lên nhé.

Tiếp theo bạn mở file robots.txt lên và nhập vào các thông tin như đề xuất của chúng tôi dưới đây, đây là file robots.txt tối ưu cho WordPress , các mã nguồn khác hoặc code khác vui lòng tìm hiểu thêm thông tin để tạo file robots.txt

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/cache

Disallow: /wp-content/plugins

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: /search/

Disallow: /*add_to_wishlist=

Disallow: *?attachment_id=

Disallow: *utm=

Disallow: */embed

Disallow: /archive/

Disallow: /wp-cron.php

Disallow: /wp-load.php

Disallow: /wp-login.php*

Disallow: /customize.php*

Allow: /wp-admin/admin-ajax.php

Allow: /wp-includes/*.css

Allow: /wp-includes/*.js

Allow: /wp-content/plugins/*.css

Allow: /wp-content/plugins/*.js

Allow: /*.css

Allow: /*.js

# Googlebot

User-agent: Googlebot

Disallow: /feed/

Disallow: /feed$

Disallow: /*/feed$

Disallow: /feed

Sitemap: https://nhanhmedia.com/sitemap_index.xmlDòng đầu tiên cho biết tài nguyên có sẵn cho tất cả rô-bốt tìm kiếm (trình thu thập thông tin).

Chỉ thị không cho phép tìm kiếm hoặc lập chỉ mục các thư mục và tệp đăng ký, nguồn cấp dữ liệu RSS, trang tác giả, trang tìm kiếm và tệp đính kèm… có chữ Disallow ở đầu sẽ chặn cào

Cho phép truy cập các file js, css trong thư mục chứa plugin, cho phép truy cập các file .js và css

Cuối cùng là địa chỉ của bản đồ XML (Nhớ thay tên NhanhMedia thành website của bạn nhé)

Lưu ý nếu bạn cho phép truy cập vào phần lưu trữ tác gì thì có thể bỏ dòng: Disallow: /author/

Lưu trữ tác giả ví dụ: https://nhanhmedia.com/author/nhanhmedia/

Hy vọng từ bài viết này các bạn sẽ setup được 1 file robots chuẩn nhất cho website của mình nhé ^^. Nếu hay hãy chia sẻ cho bạn bé biết đến nhé, cảm ơn các bạn